En la entrada anterior dimos un personal repaso a los hechos que acontecieron durante finales de los ochenta y la primera parte de los noventa, que acabaron con el dominio de IBM en el lucrativo mundo del PC, y cambiando el foco desde el hardware al software: a partir de esos años, las compañías que fabricaban hardware dejaron de ser las dominadoras del mercado, lugar en el que les sucedieron las compañías fabricantes de Sistemas Operativos y Suites Informáticas.

En ésta de hoy me centraré en las convulsiones similares que acontecieron esa década en el mundo de las llamados “miniordenadores”, y cuya consecuencia fue, por un lado, la propia pérdida del concepto de “miniordenador”, y por otra, igual que en el mundo del PC, en el cambio de foco de la rentabilidad, desde el hardware donde siempre había estado, al software (situación que continúa vigente nuestros días).

Lago Baikal, desde el espacio

Una vez más os advierto que no esperéis ningún tipo de crónica oficial, contaré todo esto tal como yo lo viví (o, al menos, como lo recuerdo), así que puede haber multitud de errores e inexactitudes, por los que os pido disculpas anticipadamente, y puede también que no estéis de acuerdo con parte de lo que os cuente… pero tened en cuenta que la memoria de este abuelo cebolleta puede tener lagunas… del tamaño del Lago Baikal, así que solicito comprensión, comprensión a espuertas…

Además, debéis tener en cuenta que todo lo que os contaré hoy sucedía simultáneamente a la guerra de los PC’s de que os hablé en la entrada anterior, y a muchas otras cosas que ocurrían en todos los frentes… Fueron años divertidos, los 90 del siglo pasado. Y estresantes, ya lo creo, muy estresantes.

Como la serie tiene ya un número apreciable de capítulos, aquí está el enlace desde donde podéis acceder cómodamente a cualquiera de ellos.

A principios de los noventa, IBM era el líder mundial de ventas (aunque veremos luego que, aunque vendía mucho, no ganaba tanto). Con sus mainframes y el software básico para ellos, dominaba sin ambages el lucrativo mundo de los grandes ordenadores empresariales, situación que, por cierto, no ha cambiado prácticamente nada hasta nuestros días, donde esa División de Mainframes sigue siendo la más rentable de IBM en la actualidad. No digo yo que sea la que más vende, sino que es la más rentable, aunque habría que saber dónde computan en los últimos años los contables de IBM los ingresos por software y servicios relacionados directamente con los mainframes… Como lo que ahora mola es que el núcleo del negocio de las empresas de tecnología sean los servicios y el software, y no el hierro, igual llevan todos esos ingresos a las Divisiones de Software y Servicios, para salir más guapos en la foto. Garabos contables, todo el mundo los hace, para contentar a los analistas financieros y que te pongan en esa categoría tan deseada de Sobreponderar…

IBM ES/9000

El Sistema ES/9000, lanzado al mercado en 1990, tenía ya muchas de las características de los modernos mainframes, y fue la base de la oferta de mainframes de IBM durante los noventa; ya entonces casi no tenía IBM competencia en este mercado, más allá de los PCM’s, los clónicos de los mainframes que comenté en esta entrada, y conforme pasaba la década, incluso esa competencia desapareció.

Pero ya dije en la misma entrada antes citada que, en este área, el problema de IBM venía del hecho de que la práctica totalidad de grandes empresas e instituciones mundiales tenían ya su mainframe, o varios de ellos… pagaban religiosamente sus cuotas anuales por el software, ampliaban sus equipos, o los cambiaban por otros más modernos y potentes… pero apenas conseguía nuevos clientes. Y eso es malo para cualquier compañía. Y lo era ya para la IBM de fines de los ochenta y los noventa.

En el mundo de los ordenadores medianos, los “minis”, IBM tenía sobre todo bien amarrado el mercado de empresas comerciales medianas, con su gama de ordenadores AS400, sucesora de los System/3x. Si estos sistemas vendían bastante era, aparte de su innegable calidad, por la cantidad de aplicaciones empresariales existentes para estos sistemas en esos años, que permitían a esas empresas sacar partido a la máquina rápidamente y sin grandes inversiones en Desarrollo.

Pero aquí sí que tenía una fortísima competencia: multitud de fabricantes tenían excelentes sistemas, la mayoría basados en algún tipo de UNIX debidamente mejorado (y patentado) por la marca: HP/UX, en el caso de Hewlett-Packard, Digital UNIX en caso de Digital (aún vendía Digital sus veteranos sistemas VAX con VMS, pero pronto dejó de hacerlo), Solaris, en el de Sun, UNIX System/5, por parte de NCR y otros, y un largo etcétera, incluyendo SCO UNIX para PC, con poquísimo mercado aún, pero creciendo. A continuación os muestro un diagrama, cortesía de la Wikipedia, de las decenas y decenas de variantes de UNIX y cómo van evolucionando de unos a otros y mutando continuamente… ¡jo, ni que fueran Pokemon!

Todos estos sistemas pequeños habían estado tradicionalmente dirigidos sobre todo a entornos de ingeniería o científicos, o para entornos técnicos, como telefonía y comunicaciones, por ejemplo, pero muy poco hacia empresas comerciales (Bancos, Aseguradoras, Minoristas, etc, o sea, las que disponían de cantidades ingentes de dinero para gastar). Pero esto, a finales de los ochenta y principios de los noventa, estaba cambiando rápidamente: por una parte, las máquinas eran cada vez más potentes (aunque, como prácticamente la totalidad seguían siendo de un solo procesador, no podían competir ni de lejos con un mainframe en esto), y por otro, el software había mejorado ostensiblemente, tanto el propio Sistema Operativo, como el resto de software de base, especialmente los Gestores de Bases de Datos. Tanto Oracle como Informix, Sybase, Ingres, y otras Bases de Datos Relacionales estaban disponibles para los diferentes olores, sabores y colores de UNIX, y esto permitió aumentar la oferta de estos sistemas para aplicaciones empresariales y comerciales que hasta entonces habían sido prácticamente coto vedado de mainframes.

HP 3000 (año 1985)

Hewlett-Packard tenía en el mercado desde mediados de los setenta su serie HP3000, con el Sistema Operativo MPE, y una más que probada fiabilidad, que le había generado suculentas ventas durante muchos años (de hecho, la serie 3000 sólo se dejó de vender en 2003). Pero tras la adquisición de Apollo Computers en 1989, y la inclusión de sus nuevos procesadores PA/RISC, potenció la serie de estaciones de trabajo HP9000, equipada con HP/UX, entrando como una locomotora en el mercado de servidores, y convirtiéndola pronto en su buque insignia.

Si añadimos que Hewlett-Packard dominaba el mercado de impresoras para PC, y que era uno de los fabricantes de clónicos de PC con más actividad comercial, podemos añadir al cóctel de su buena gama de productos una respetable posición empresarial. Estaba ya considerado como “una empresa seria” por parte de sus potenciales clientes; iremos viendo que esta respetabilidad resultó un factor importante de éxito en lo que iba a venir.

Varias compañías fundadas a principios de los ochenta estaban también creciendo a marchas forzadas, fabricando y vendiendo estaciones de trabajo y servidores de gran calidad basados en UNIX (cada una, en su UNIX, naturalmente, hasta ahí podíamos llegar: todo el mundo intentaba crear su propio mercado cautivo…).

Una de ellas era Silicon Graphics, especializada en costosas workstations, sobre todo en el mundo del diseño gráfico, el vídeo, y los gráficos avanzados en entorno técnico. Aplicaciones todas ellas que requerían una potencia de hardware inalcanzable para los PC’s o las workstations normales de la época (las más orientadas al propósito general). En este mercado del tratamiento de vídeo tuvieron una posición prominente hasta fines de los noventa (los estudios de Hollywood fueron tradicionalmente sus mejores clientes), pero cuando la evolución tanto del software como del hardware hizo que hasta los PC’s más normalitos tuvieran buenas capacidades para tratar vídeo… pues lo pasaron mal. Realmente mal. Tanto, como que se han declarado en bancarrota recientemente…

Sun 150 (año 1983)

Por su parte, Sun, que había estado exclusivamente dedicada a las workstations, basadas a partir de 1987 en su propio procesador SPARC, entró también en el mercado de servidores a partir de 1992 o 93, ofreciendo máquinas de procesamiento simétrico (SMP) con buenos rendimientos y mejor precio, que usaban como software… su propia versión de UNIX, claro: Solaris.

Sun fue ampliando su gama de servidores, cada vez más potentes, más fiables y con mejor precio, y fue adquiriendo una buena posición en este mercado, que mejoró ostensiblemente a raíz de su fervorosa adhesión al mundo naciente de internet, sobre todo a raíz de la publicación de Java en 1995… Y consiguió muchas ventas, mucha rentabilidad, y se convirtió en uno de los líderes de fines de los noventa… y de los que más sufrió a raíz del estallido de la burbuja puntocom, en 2001. Y tras unos años complicados, como seguramente sabéis, ha sido recientemente adquirida por… Oracle. Nada menos que por Oracle, una compañía dedicada desde el comienzo al software y los servicios… Pero ésa es otra historia y será contada en otro momento.

Volviendo a los noventa, en 1994 Sun había comprado a Thinking Machines, compañía especializada en la fabricación de supercomputadores vectoriales (entre las compañías especializadas en proceso vectorial, destacaban además CRAY, que fue comprada por Silicon Graphics, luego separada, revendida otra vez, y que continúa existiendo en la actualidad, y Convex, comprada por Hewlett-Packard). Incorporando en parte la tecnología de Thinking Machines, Sun fue capaz de poner en el mercado servidores SMP con Solaris, y con decenas de procesadores, y una ingente capacidad de proceso, en la segunda mitad de la década de los noventa.

Digital Equipment, otro de los grandes competidores del mercado mini, estaba, en cambio, pasándolo mal.

DEC PDP-1 (año ¡1960!)

En 1960 inventaron el concepto de miniordenador (los de Digital fueron los primeros, con el PDP-1, aunque viendo la foto de la derecha, a duras penas podemos pensar que eso fuera un miniordenador… ¡cómo serían en los sesenta los ordenadores-a-secas…! Digital había dominado el mercado de minis, sobre todo a partir del lanzamiento del PDP-8, en 1965, y durante toda la década de los setenta y ochenta, gracias a sus series PDP y VAX. Pero no había encajado bien el cambio vivido en la informática a partir de la llegada del PC.

Tras intentar encontrar su hueco en este mercado sin éxito, su respuesta final fue la creación del nuevo chip Alpha, lanzado en 1992, con arquitectura RISC, de 64 bits y una excelente calidad… y elevado precio. El mercado no estaba preparado para un procesador tan novedoso (léase: potente y caro), y además hubo que modificar los Sistemas Operativos para que usasen este avanzado chip: tanto VMS, como Digital UNIX y Windows NT debieron sufrir una costosa adaptación.

Cuando Digital lanzó por fin la gama AlphaServer, en 1994… ya era tarde. Pocos años después, fue comprada por uno de sus competidores, uno impensable hasta hacía muy poco tiempo: Compaq, que había conseguido su solvente posición fabricando y vendiendo PC’s. ¡El acabóoose! (imitando la grave voz de Fernando Fernán Gómez), pensamos muchos… Claro que poco antes Compaq había adquirido también a Tandem Computers, así que tampoco era tan raro, ¿no?

Y la propia Compaq pagó en sus carnes los excesos de la “burbuja puntocom” pocos años después, y fue a su vez adquirida por Hewlett-Packard… pero ésa es otra historia y será contada en otro momento.

Había muchos más fabricantes de Sistemas UNIX (Philips, Unisys, NCR, Nixdorf, y un largo etcétera), cada cuál defendiendo su pequeña parcela con uñas y dientes, e intentando arañar un pedacito de la parcela del vecino…

Y por fin, la propia IBM se había dado cuenta, a finales de los ochenta, del creciente potencial de este tipo de sistemas, los, hasta hacía poco, denostados (por IBM, quiero decir) “miniordenadores”, y decidió entrar también en el mercado de los sistemas pequeños basados en UNIX. Y ¡cómo lo hizo!… a lo grande, como IBM solía hacer las cosas: sacó al mercado la gama RS/6000, equipada con novísimos procesadores RISC: los POWER, de diseño propio, como todo el resto de componentes, siempre con tecnología propietaria y protegida por cientos de patentes, a la manera IBM. Como Sistema Operativo, era un UNIX, sí… pero, cómo no, uno con patente de IBM: AIX, para acabar de liar la madeja de UNIX y más UNIX que había en el mercado… Y completó su salida al mercado con el lanzamiento de gran cantidad de software básico, entre ellos DB2/6000, la versión de su Base de Datos Relacional para entornos UNIX.

IBM RS/6000, año 97

Sin embargo, para IBM no era éste un mercado conocido. Tuvieron que crear la tecnología, contratar o formar a sus técnicos, a sus comerciales, lanzar una estrategia de marketing, etc, en una palabra, necesitaron un tiempo para asentarse en el mercado y ser percibidos como un competidor fiable en el mundo UNIX. Para agilizarlo, se asociaron a todas las asociaciones habidas y por haber, como la OSF, y a todos los estándares, como POSIX (al menos, de boquilla, como casi todos)… y todo ello para crearse una reputación de “apertura” que el mercado (es decir, nosotros los clientes) estaba empezando a valorar, aunque a duras penas se encontraba un sistema “abierto” de verdad esos años…

Y esta última afirmación la hago con conocimiento de causa, pues en aquel tiempo diseñamos y escribimos en mi empresa una aplicación magnífica sobre un servidor HP9000 con HP/UX, graciosa y muy bien parida, pero no muy complicada, que funcionaba muy bien. Luego, por causas diversas que no vienen al caso, hubo que migrarla primero a un servidor Digital, luego a un RS/6000 de IBM, al poco tiempo a un Sun con Solaris… y cada migración fue un dolor de cabeza, tanto que casi tardábamos más en migrar la aplicación de UNIX a UNIX que lo que habíamos tardado en escribirla (en realidad estoy usando el plural mayestático, porque quien escribió la aplicación fue mi equipo; yo me limitaba a planificar, exigir, premiar y castigar, je, je).

¡Me van a contar a mí lo de los Sistemas Abiertos de los noventa…! No sé qué pasará ahora con los Linux, no estoy en ese negocio… pero lo que oigo es que pasan cosas parecidas, aunque con menor intensidad que con los dichosos UNIX de los noventa… Algo se habrá aprendido en quince años, digo yo.

El caso es que sobre los años 91-92 del pasado siglo había una considerable oferta de sistemas UNIX de diferentes fabricantes, pretendidamente intercambiables entre sí, gracias a que UNIX aseguraba (o así) la portabilidad de aplicaciones, con cada vez mayor capacidad de proceso y almacenamiento, y un precio realmente competitivo, si lo comparamos con el que tenía un mainframe tradicional.

Poco a poco fueron canibalizando (en parte, al menos) las hasta entonces exclusivas señas de identidad del mundo mainframe, a saber: Fiabilidad, Potencia de Cálculo, Compatibilidad hacia delante, buen soporte, etc. Y con mucho menor coste aparente.

Pero lo que pasaba es que las grandes empresas no tenían apenas Técnicos de Sistemas UNIX, de ninguna clase de UNIX, si es que tenían alguno. Ni Analistas, ni Programadores. Ni Operadores. Ninguno. Así que, además de comprar las máquinas y su software básico, había que comprar el resto de software necesario, de comunicaciones, formar (o fichar) a los técnicos, usuarios… Además, resulta que UNIX (al menos los de la época), se volvían inestables cuando la CPU llegaba más allá del 70-80% de su capacidad… pero la publicidad no decía nada de todo esto, claro está.

En definitiva, vale que tanto las máquinas como el software eran sensiblemente más baratos que un buen mainframe, pero una migración a este tipo de sistemas tenía unos elevados costes ocultos… que nadie reconocía, naturalmente. Además, es posible que a las empresas, es decir, a los clientes finales, sí que les importaran los costes ocultos, pero, a las Consultoras, Compañías de Servicios Profesionales, y a los propios fabricantes… ¡De ninguna manera!

Todo lo contrario, de hecho: vieron una oportunidad de oro de elevar sus ventas, sus márgenes, su facturación y, en definitiva, la retribución del Consejo y de los accionistas.

¡Todos a Una! Tonto el último...

Así que se lanzaron, todos a una, a la yugular de la durante tanto tiempo prepotente IBM (encarnada, fundamentalmente, en su hasta hacía muy poco omnipotente División de Mainframes).

Los argumentos que utilizaban eran, no hay precisamente que ser un genio para darse cuenta, demoledores:

1) Estábamos promocinando la nueva tecnología, en contraposición con la vieja tecnología del mainframe. Que ésta fuera probada, potente, fiable y bien conocida, en realidad, no importaba nada. Más bien al revés…

2) Con tantos competidores y una competición tan intensa entre ellos, la tecnología iba a evolucionar rápidamente, proporcionando previsiblemente grandes aumentos de rendimiento y sensibles bajadas de los precios en un futuro próximo.

3) Precios que, además, ya eran más bajos que los de la tecnología de los dinosaurios.

4) Como ya se vislumbraba el boom de internet en el horizonte (estamos en 1993-1994, más o menos), se requerirían nuevos servidores… muchos servidores, y no íbamos a cometer la estupidez de comprar caros mainframes para tales cosas mundanas…

5) Y por si fuera poco, ¡ni siquiera se programaban en Cobol!, esa vieja cosa del Cretácico Medio, sino en los modernos lenguajes orientados a objetos, que nos iban a solucionar la vida en un pis-pas, porque en muy pocos años, nadie programaría ya nada, sino que tomaría objetos de aquí y de allá, los ensamblaría todos juntos, y voilà: su aplicación a su antojo en tres días… Vale, también se podía programar en Cobol, que había excelentes Coboles para UNIX… pero ¿a qué neanderthal se le ocurriría hacer tal cosa, y no contratársela a su proveedor favorito de Servicios Profesionales, para que la hiciera en Visual Basic, en C, en C++, o en cualquier otra cosa de moda?

Tenía yo una agenda que se publicó sobre el noventa o noventa y dos, que hacía previsiones sobre qué nuevas tecnologías aparecerían en los próximos cincuenta o sesenta años, qué sé yo… Decía cosas como: 2000: Se impone el coche eléctrico. 2011: Se consigue por fin la energía de fusión. 2028: Se establece la primera colonia humana en las lunas de Júpiter… y así todo.

Bueno, pues, en la agenda, las previsiones para (por ejemplo) 1998, eran: Abandono definitivo del Cobol. Y en 2003, decía: El Cobol es definitivamente sustituido por lenguajes más modernos. Y en 2008: Sustitución definitiva de Cobol como lenguaje de programación… y así cada cinco años. 2048: Por fin se elimina completamente el lenguaje Cobol… Etc, etc. En el resto de predicciones no dio ni una, pero en ésta del Cobol, acertó de pleno: ¡No pasan cinco años en los que no se abandone de una vez por todas el dichoso Cobol!

Anuncio de la época de una Consultora

Bueno, pues sólo quedaba, para redondear la estrategia de acoso y derribo al líder, dotarla de un acompañamiento adecuado de marketing: había que acuñar un término efectivo, poderoso, muy comercial, para que cualquiera pudiera identificar el mensaje… y el término elegido fue… Downsizing.

El significado original de la palabreja es parecido al término hispánico de ERE (Expediente de Regulación de Empleo): Eliminar personal (despidiéndole, sólo despidiéndole y mandándole al paro…) para aumentar así la eficacia de la empresa.

Y como estábamos atravesando la consabida crisis del 92-93, el término dichoso tuvo inmediata aceptación: a los oídos de los Directores Financieros, de Tecnología, de Recursos, etc, a todos ellos el mensaje les sonaba a música celestial: gastarse mucho menos dinero por lo mismo es un dulce que a nadie amarga…

La cruda realidad era que ni era tanto menos dinero, ni era por lo mismo.

Sí, cierto, pero… ¿y a quién le importaban esas menudencias a la hora de vender un buen Plan Estratégico, seguido de un millón de horas/hombre de recursos cualificados…?

Comenzaron a proliferar por doquier Conferencias y Charlas varias, por no hablar de artículos en revistas del gremio, en las que ponente tras ponente, escritor tras escritor (todos ellos cualificadísimos) nos evangelizaban, una y otra vez, sobre las indiscutibles ventajas del downsizing.

Ponente tras Ponente... todos decían lo mismo: ¡Downsizing YA!

Todo eran ventajas. Ningún inconveniente, of course. Y si hubiera alguno, aquí estamos nosotros para solucionárselos… ¡faltaría más!

Los mensajes comenzaban, indudablemente, a calar entre los clientes: es difícil oír una y otra vez a uno tras otro prestigioso consultor explicándote lo bueno del downsizing, lo malo de permanecer anclado a una tecnología llamada a desaparecer en breve (sí, eso se repetía una y otra vez: los mainframes estaban condenados a desaparecer en no más de cinco años), la cantidad de dinero que estabas tirando día a día a la basura… y seguir en tus trece. Máxime cuando al Jefe del Jefe de tu Jefe también le cuentan las mismas cosas los Jefes de los Jefes de los Consultores que te lo cuentan a ti…

Una pregunta que oí muchas veces en aquellos años, era: “…y en vuestra Organización… ¿cuándo vais a tirar los mainframes de una vez y sustituirlos por una buena granja de servidores UNIX y PC’s (peazo dinosaurios, que sois unos triceratops…)?“ Lo que está entre paréntesis no lo decían, claro está (salvo que fueran muy, muy amigos), pero lo pensaban, todos lo pensaban…

Incidentalmente, en 1993, Microsoft lanzó, por fin, su esperado Windows NT. Jaleado por todos los fabricantes de PC’s (excepto, claro está, IBM, que aun así tuvo que ofrecer Windows NT también en sus sistemas PS/2), por los consultores, las casas de software independientes, etc, resultó un gran éxito, quizá no de ventas de forma inmediata, pero sí mediático, con lo que la carrera de OS/2 languideció definitivamente.

Además, y como es lógico, los fabricantes de software de base (los de Bases de Datos, sobre todo) se lanzaron rápidamente a migrar sus productos a Windows NT, aumentando los sistemas susceptibles de recibir sistemas “downsizingueados” (perdón por el palabro, no he podido resistirme), y por ende la subsiguiente presión adicional para IBM (y los fabricantes de clónicos de los mainframes, que lo pasaron tan mal que, en la práctica, o se dedicaron a otras cosas, o simplemente desaparecieron en pocos años).

Números Rojos (Muy Rojos) en IBM

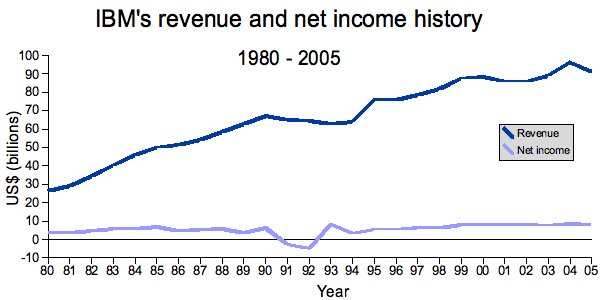

De todos modos, y a pesar de su indiscutible liderazgo tecnológico y en ventas, IBM lo estaba pasando mal también. Vendía más que nadie, sí, pero una vez hechas las cuentas… la de resultados (la única que de verdad importa) terminaba en números rojos. Cada vez más rojos, hasta que en el ejercicio fiscal 1992 anunció pérdidas de nada menos que 8.100 millones de dólares de la época, las mayores jamás registradas hasta entonces por ninguna compañía del mundo mundial (aunque dadas las cifras que se manejan ahora en nuestra crisis cotidiana de cada año, estas cifras nos parecen ridículas). IBM siempre hacía todo a lo grande, como podéis ver.

Había muchas causas: la División de Mainframes era rentable pero estaba sobredimensionada (recordad que quedaban pocas empresas susceptibles de comprar un mainframe que no lo tuvieran ya), la anterior mina de oro de la División de Sistemas Personales (los PC’s, vaya) sufría una fortísima competencia que había erosionado sus márgenes hasta comérselos, la División de Sistemas Generales (la que vendía AS/400) sufría fuerte competencia de los fabricantes de minis… entre los que estaba la propia División de Sistemas UNIX de IBM, con sus novedosos RS/6000, que todavía no se habían consolidado en el mercado UNIX, además de todas estas causas tecnológicas, había también causas financiero/contables, debidas a un cambio de estrategia en la venta o alquiler de equipos, que no voy a detallar más para no ponerme pesado…

En una palabra, tenían una estructura balcanizada, con multitud de laboratorios, de Divisiones (muchas veces enfrentadas entre sí), de gama de productos, muchos de los cuales no eran rentables, pero se mantenían en catálogo… y además, comercialmente (lo que había sido su fuerte de toda la vida), no lo estaban haciendo bien tampoco.

Por ejemplo (y esto lo he visto yo con mis propios ojos), tú eras un cliente cualquiera, y hacías una petición de ofertas para un nuevo sistema a diversos fabricantes. Recibías una de Hewlett-Packard, otra de Digital, otra de Sun… y tres de IBM: una con un mainframe, otra con AS/400 y otra con RS/6000. La fuerza comercial de Hewlett-Packard defendía a muerte su oferta, la de Sun, la suya… y la de IBM defendía tres. Contradictorias, incompatibles entre sí. Cuando venía el técnico de preventa de AS/400 a defender la suya, te decía que eso del UNIX no valía para nada (incluyendo, sin citarlo, al RS/6000 con AIX, claro). Después llegaba el del mainframe y te aseguraba que cualquier sistema pequeño no te serviría (ninguno, tampoco los de IBM) y sólo un buen mainframe podría funcionar… y así. Comercialmente hablando, es una postura suicida… y que a poco le cuesta la desaparición a IBM.

La verdad es que la gestión de John Ackers, Presidente y CEO de IBM durante esos años cruciales, fue bastante nefasta para ellos; no supieron adaptarse a los cambios del mercado, parte de los cuáles ellos mismos habían provocado, no previeron el comportamiento futuro del mercado… o quizá es que el mercado no se comportó como ellos pensaban. El caso es que las cifras negativas estaban ahí. ¡Y gritaban!

Y además, desde mi punto de vista, lo más curioso es que ellos mismos habían llegado a creerse todo el argumentario de la competencia, y se habían convencido de que la tecnología de mainframes estaba obsoleta y había que desmontar (o vender al mejor postor) toda la División, así que estaban preparando (de hecho, estaba el Plan ya muy avanzado) una disgregación de la compañía en los diferentes negocios para venderlas después, al mejor estilo de Richard Gere en Pretty Woman…

Lou Gerstner, CEO de IBM, 1993

Sin embargo, entre los accionistas de IBM, alguien seguía teniendo las ideas claras: en abril de 1993 contrataron a un nuevo CEO: Lou Gerstner. En el mundillo informático nos causó estupor: este Señor provenía de RJR Nabisco, una compañía alimentaria, especializada en vender galletas y tabaco… ¡no sabía nada de dirigir una empresa de tecnología! El que más, el que menos, pensamos: “Buff, estos de IBM se han vuelto definitivamente locos: se van a la quiebra en dos días…”

Pues, mira tú por dónde, no. Resulta que Lou Gerstner sabía sobre todo de dos cosas: cómo funcionaba el mercado de consumo, y cómo organizar una empresa enorme y variopinta. Y además, conocía muy bien a IBM como cliente… Y eso era exactamente lo que entonces necesitaba IBM. Canceló toda segregación de la compañía, pero impuso un régimen de adelgazamiento brutal en aquellas áreas que no eran rentables.

Pero sobre todo, sobre todo, se dio cuenta de que el negocio tradicional de IBM había cambiado, que era lo que no habían sabido ver sus antecesores. IBM había ganado dinero a espuertas, durante toda su historia, fabricando unos cacharros excelentes, y vendiéndolos con elevados márgenes, que pudieran compensar los costes de desarrollo. Pero ese modelo de negocio basado en el hardware estaba tocando a su fin: el futuro era de los intangibles: el Software y los Servicios Profesionales. Y lo sigue siendo, por cierto. Vale que hacen falta máquinas para que ese Software funcione, pero cada vez más son consideradas como puros commodities, intercambiables, con escaso valor añadido. En el mundo de los PC’s, desde luego pasa ya (lo último que miras al adquirir un PC es su marca, ¿cierto?), y en buena medida pasa también con los servidores UNIX o Windows…

Gran expectación alrededor de las posibilidades de Gerstner en IBM

En poco tiempo, IBM se convirtió, de ser un proveedor virtualmente monomarca (la suya, claro) a uno de los integradores de Sistemas más activos, compitiendo con Andersen Consulting, Coopers & Lybrand, Price Waterhouse, etc en su propio terreno: la Consultoría e Integración de Sistemas. Firmó acuerdos con prácticamente todos los fabricantes de cualquier cosa. Y, encima, los puso en acción.

Los clientes, atónitos, comenzamos a recibir ofertas de IBM donde había, por ejemplo, una máquina Sun E10000 con Solaris, una Base de Datos Oracle, algún otro producto de gestión de IBM o de terceros, y Servicios Profesionales de IBM (lo que se convertiría en lo que hoy es IBM Global Services). No nos lo podíamos creer, ya digo: “El Acabóse”…

Pero… funcionó.

Pusieron en la calle a decenas de miles de personas, con unas condiciones de salida realmente interesantes, casi todas ellas técnicos de sobrada valía, que casi en su totalidad encontraron rápidamente trabajo entre sus clientes u otros proveedores. Varios compañeros míos proceden de aquellos años, y doy fe de que son unos excelentes profesionales. Parecía que IBM, sin sus mejores técnicos y comerciales, no duraría mucho. Duró.

A mediados de los noventa volvió a ganar dinero. Poco, quizá, comparado con las ingentes cantidades de años anteriores, pero eran números negros. Y así, creciendo, siguen hasta hoy. Mi personal opinión es que IBM va a ser con toda probabilidad una de las ganadoras de la RecojoCrisis del 2008-09-??.

Aquí tenéis un gráfico con la evolución de Ventas y Beneficios de IBM desde 1980 a 2005. ¿Se nota el bache brutal de los primeros noventa, coincidiendo por cierto con la consabida crisis de esos años, y cómo se recuperó en años sucesivos? Mérito de Mr. Gerstner.

Mientras todas estas cosas pasaban, algunos clientes habían empezado proyectos serios de downsizing, que siempre tiene que haber alguien que empieza… y, como podéis imaginaros, las cosas no eran tan sencillas como el corifeo de consultores aseguraba, ni con todos los técnicos posibles echando una mano. Ni el hardware ni el software estaban maduros. Los que arrancaron estos proyectos esperaban un proyecto rápido, de bajo coste, y, sobre todo, una aplicación resultante al menos tan eficiente como la sustituida, más sencilla de mantener y, además, con colorines… pues prácticamente todas estaban escritas siguiendo la tecnología Cliente/Servidor (el otro gran hallazgo marketiniano del momento), es decir, los usuarios manejaban un PC con ratón y ventanitas de colores, conectado generalmente mediante una red de área local con un servidor.

Hubo algunos descalabros importantes, yo conozco alguno de ellos; hubo quien tuvo que dar marcha atrás, y todos los proyectos, sin excepción, duraron mucho más de lo previsto, costaron sensiblemente más de lo presupuestado, y pocas veces cumplieron las expectativas de funcionalidad y coste de mantenimiento.

Pero es que, además, muchísimos Usuarios Finales habían comenzado a mecanizar sus aplicaciones sin la intervención del Departamento de Informática. Y es natural: los Usuarios tienden a desear que se solucionen sus problemas de forma rápida, sencilla y barata, y cuando nos explicaban sus necesidades a los de Proceso de Datos, y allí les dábamos plazos de varios años, y costes monstruosos para resolverlos… pues no les gustaba. Pero nada de nada.

Muchos de ellos (de los Usuarios, quiero decir) buscaron alternativas, y se buscaron la vida, dotándose de aplicaciones que resolvían, más o menos, sus problemas inmediatos. Usaron diferentes estrategias, desde contratar directamente a algún suministrador sin el conocimiento de Informática (o con su conocimiento y subsiguiente cabreo), o bien, y esto era lo más normal, resolviéndoselo él solito, con una buena Hoja de Cálculo toda llena de macros, una Base de Datos Microinformática o directamente encargando la aplicación a su sobrino, estudiante de informática en una academia, y mago del Basic.

Todas estas aplicaciones “extraoficiales” se montaron sin excepción en PC’s, casi siempre standalone, y en algún caso con servidores (también PC’s, rara vez una máquina UNIX), nunca en mainframe, ni siquiera en Sistemas UNIX, con las Bases de Datos, ya bastante robustas, de la época.

Y claro, cuando hubo que ampliar, expandir o modificar estas aplicaciones… hubo problemas. Serios problemas.

Así que, inevitablemente, hubo una reacción “anti-downsizing”: un nuevo palabro apareció en escena: el upsizing. Me extraña, por cierto, que lo que dice la Wikipedia sea verdad: que fue Microsoft quien acuñó el término refiriéndose a pasar aplicaciones de Access a SQL Server… a lo mejor sí, pero desde luego aquí en la Piel de Toro no se usaba para eso (al menos, no exclusivamente para eso).

Aplicaciones Desparramadas...

Con ese término nos referíamos al movimiento de las aplicaciones distribuidas (muchas de ellas, literalmente desparramadas) a un entorno centralizado (no necesariamente mainframe, aunque también). En efecto, esas aplicaciones basadas en PC, baratitas y con no muchas pretensiones, pero que con el tiempo se habían convertido en aplicaciones importantes para las empresas… fue entonces cuando comenzaron a mostrar crudamente los problemas de esa aproximación pecera: falta de integración, diversidad de versiones, incompatibilidad con otras aplicaciones, dificultad de acometer nuevas versiones, graves problemas de recuperación en caso de fallo, etc… o sea, todo lo que había nos costado años aprender en el entorno centralizado de toda la vida, y que últimamente se nos había olvidado… y que hubo que recordar a marchas forzadas.

También se hicieron proyectos de upsizing… y también con problemas. Porque ahora sí que había integridad de datos y funciones… pero con un interfaz que no cubría las necesidades de los usuarios (que habían visto, o al menos entrevisto, lo útil que puede llegar a ser un buen sistema de ventanas…).

Y llegamos, por fin, a inventar el término definitivo: ¡Rightsizing! Es decir, más o menos: “Seleccione la tecnología y ubique las funciones de su Sistema de tal modo que se usen las diferentes máquinas y software disponibles para lograr un rendimiento, interfaz y coste perfecto”. Es decir: ¡Acierte Usted! Sin bola de cristal, eso sí.

¡Pues vaya! Nosotros que pensábamos que eso es lo que habíamos estado haciendo toda la vida… y resulta que ahora se llamaba “rightsizing”, cuando creíamos que se llamaba trabajar…

En fin. Ninguno de estos términos tuvo éxito a la larga (porque a la corta, ya lo creo que sí). De hecho, ni siquiera se encuentran sus definiciones adaptadas a la tecnología informática en la Wikipedia, es decir, se ve que ahora lo llamamos otra vez trabajar… Porque para eso nos han pagado desde que la profesión existe, digo yo.

El caso es que los noventa vieron cambiar por completo el papel de los elementos tecnológicos informáticos: el hardware dejó de ser importante, comenzó a convertirse en lo que hoy es: una commodity; y sin embargo el software se convirtió en lo realmente importante, en lo que hacía la distinción entre un sistema bueno y uno malo… Eso y los servicios profesionales, desde luego.

E internet, claro. Con la progresiva introducción y aceptación de internet, y la sensible mejora de las capacidades de redes y líneas telefónicas, el uso de un navegador prometía, de una vez por todas, lo mejor de los dos mundos: Aplicaciones centralizadas, sí, con todas sus ventajas, pero con presentación gráfica ante el usuario, y todo por un coste muy ajustado, sobre todo de licencias, dado que en el equipo cliente no se necesita ningún software adicional. Y todo el mundo comenzó a hablar de internet, y a probar, y a montar su página web, sus primeras aplicaciones intranet… Pero ésa es otra historia y será contada en otro momento.

Los PC's llegaron en masa a los hogares

Y por fin, tal y como se estaban abaratando los PC’s, así como el software, y tal y como estaban apareciendo más y más programas orientados al usuario doméstico (empezando por los juegos, claro), muchísimos nos empezamos a comprar un PC para casa, con la excusa de llevar las cuenta domésticas, escribir las cartas a tu primo el de Valladolid y aprender a programar en no sé qué esotérico lenguaje… aunque en realidad todos lo usamos para jugar al Quake, el único y definitivo Quake que funcionaba en MS/DOS… Mi primer PC de casa (mediados de 1996) fue un clónico con un Pentium-a-secas de 166Mhz, 16Mb de RAM, 60 Mb de disco duro, una pantalla VGA de 15”, disketera, por supuesto, y lector de CD’s, con Windows 95, y todo al módico precio de unas 350.000 pesetas de la época (2.100 Euros)… ¡y eso que ya habían bajado mucho de precio!

Y en las empresas fue definitivamente durante esos años cuando se puso de moda contratar compañías de Servicios Profesionales para hacer parte del trabajo de desarrollo (o de cualquier otra función de Proceso de Datos), incluso el desarrollo completo de los proyectos, aligerando la plantilla propia y subcontratando más y más personas de más y más compañías… Había que “convertir el gasto fijo en variable”, mantra que se oía por doquier, y que sonaba muy, pero que muy bien a los directores financieros y de Recursos Humanos: No se cargue Vd. con costosos e inflexibles recursos propios, subcontrate Vd. todo lo que pueda (mejor: ¡Todo!, y mejor aún, ¡A mí!) y en caso de necesidad, siempre podrá Vd. eliminar subcontratación y aligerar gastos sin incurrir en despidos… O sea, pague Vd. a precio de Oro el programador a la empresa TalyCual, SA, que ya se encargará esa empresa de pagar al susodicho programador un sueldo de hambre… pero, eso sí, cuando Vd. lo desee, la empresa TalyCual, SA despide al programador, y Santas Pascuas…

No sé si os suena de algo… pues toda esta política del contrato basura se gestó durante los primeros noventa; hasta entonces había poca subcontratación (en España, me refiero, que es lo que conozco). Y la triste realidad es que, para mantener las aplicaciones funcionando, se necesita siempre un plantel determinado e irreducible de técnicos, o sea, que eso de que los gastos eran variables… sólo hasta cierto punto. Y eso es lo que están viviendo muchas empresas en nuestros atribulados días: ahora que con la consabida crisis ha llegado el momento de eliminar gasto variable… resulta que no se puede, al menos no se puede tanto como querrían, porque ¡alguien tiene que mantener funcionando las aplicaciones de la Compañía!.

Y así andamos…

Y ya está bien por hoy, me parece a mí, que me pongo a escribir y es que no sé parar…

En la próxima entrada hablaré del nacimiento de unos de los conceptos clave de la informática de nuestros días: El Data Warehouse, y sus colaterales: el Data Mining, el Business Intelligence, etc, aunque contar toda esta historia me llevará más de un artículo.

Sin embargo, podéis estar tranquilos, queridos lectores, que ya queda poco: la serie se va acercando a su final…

Disfrutad de la vida, mientras podáis.

The Historia de un Viejo Informático. Los tormentosos años noventa(II): La imparable ascensión de los “minis”. by , unless otherwise expressly stated, is licensed under a Creative Commons Attribution-Noncommercial-No Derivative Works 2.5 Spain License.

{ 26 } Comentarios

Me parece excelente la serie de artículos. Todo esto me da una idea mas clara de como a sido la evolución de la informática y de las TI’s. Ademas el punto de vista desde que lo narras me parece genial, por lo que aquí seguiré leyendo la serie y en espera de la próxima entrega que realmente me llama mucho la atención la parte del DataWareHouse y en concreto lo del Business Intelligence.

Saludos!!!

Si pretendías darnos ánimo con eso de que la serie va llegando a su final creo que has conseguido el efecto contrario: no queremos que esto termine, nos gustan tus artículos, y por eso volvemos a esta página a leerte.

También es cierto que cuando llegues al presente tendrás que parar, a menos que puedas avistar el futuro y contarnos lo que está por venir. De hecho me parecería buena ídea que terminaras con unas predicciones: basandote en tu experiencia (que ya se ha visto que es amplia y larga), me gustaría que hicieras unas proyección de lo que piensas que podría llegar, y como podría evolucionar este submundo nuestro que es la informática.

Saludos, y muchas gracias por compartir con nosotros tus recuerdos.

“la serie se va acercando a su final”

‘amos ¿no me jodas que esto acaba?

De tranquilos nada, si pienso que se va a acabar la serie me entran sudores frios. Además, con la cantidad de veces que has dicho “Pero ésa es otra historia y será contada en otro momento” tienes material para rato.

Yo he trabajado en un par de empresas de estas en las que estas de externo en el cliente, y aunque no he estado en ninguna de las que la peña echa pestes, no es un curro que me guste demasiado (en cuanto pude escapé y agur consultoras charcuteras). Oiga, a cuanto el kilo de programador? A X€ el kilo, tome, un experto en Cobol, expertisísismo!! … y a lo sumo has hecho un cursillo…

A ver, a ver… que no cunda el pánico, Señores y Señoras.

Todavía quedan tres o cuatro, quizá cinco artículos. Pero después de eso, la serie se acabará. Es lo mejor, creedme.

Nunca ha sido mi intención ser un “publicador regular”; si lo hubiera querido (o podido) ser, hubiera creado mi propio blog, o le habría contratado el diseño a alguna Consultora-Buena-De-Toda-La-Vida, y hubiera publicado allí. Sin embargo, fue la insistencia de Pedro y de otros doctos comentadores de ElTamiz/Elcedazo los que han impelido a escribir esta serie.

Si se ha podido publicar a un ritmo aproximado de una entrada semanal, es simple y llanamente porque primero escribí el guión de todos y cada uno de los episodios, luego los escribí completamente… y hasta que no tuve cinco o seis completamente preparados, no comenzamos a publicar. Este pequeño stock de artículos en la nevera es el que ha permitido dar continuidad a la serie, pues si no, hubiera sido mucho menos regular. ¿Se nota que uno ha sido Director de Proyectos Enormes, y ha aprendido (a palos) a planificar… y a cumplir los plazos?

De hecho, los tres episodios en que se divide el rollete del Data Warehouse, el Business Intelligence, etc, están ya escritos y más o menos preparados para publicar… pero cada vez dispongo de menos tiempo para poder escribir con la calidad mínima que este Viejo Cascarrabias Gruñón se exige a sí mismo, por lo que lo poco que queda va despaciiiito, despacito.

Y preparar cada entrada (del tipo de las mías, quiero decir) lleva tiempo. Mucho tiempo, horas y más horas. Incluso teniendo preparado el guión y teniendo claro, clarinete lo que quieres contar. ¡Y eso que tengo el Verbo fácil! Pedro, Lucas, Mazinger o cualquiera de los (excelentes) autores que publican en ElTamiz/Elcedazo seguramente corroborarán esto.

De verdad, hacedme caso. Es mejor que la serie termine, en un mes o así.

Y, por qué no, es posible que más adelante vuelva a publicar otra serie sobre cualquier otra cosa: Jardinería, La Sinfonía Romántica, Cómo resolver Sudokus, El Bricolaje Fácil, La Ciencia Ficción primigenia, Los Tercios Españoles, El Amor en los Tiempos del Cólera (Ah, no, aquí se me adelantó D. Gabriel…). Ya véis que mis aficiones son variopintas: Aprendiz de Mucho, Maestro de Nada. Pero, eso sí, cuando decida escribir una nueva serie, lo haré igual que he planificado y escrito ésta: las costumbres son las costumbres…

But don’t worry!, de momento, disfrutemos de lo que queda…

Saludos a todos y gracias por vuestros amabilísimos comentarios (as always)

jajaja, lo dicho que me parto porque parece que estás contado mi biografía, jeje y que no puedo pues mañana he de seguir “rightsizingueando” (¡toma “palabro”!) para la empresa, ¿Haber si aciertas cuál?, jeje, pues “IBM Global Services”, es decir IBM-España. Además el nombre que le han puesto a mi nuevo PC (por supuesto es, por como yo llamaba al anterior) es “new diplodocus”… Cambiando de tema: ¿No piensas que con todo el rollo éste de la crisis financiera el open source sería una de las soluciónes? (tanto para programadores como para consultores, tecnicos, operadores…) “pero ésa es otra historia y será contada en otro momento”, jajaja. ¿Te suenan las palabras que se encuentran entre comillas?

¿Que la serie…. que la serie se va a acabar? ¡AAAAAAaaaaAAAAaaaaaAAAAARggggG!

No, ahora en serio: creo que es como debe ser. Que se acabe la serie no quiere decir que Mac no vuelva a escribir aquí, ni nada parecido. Puede contar otras historias, de informática y de otras cosas, pero la crónica no puede estirarse porque perdería sustancia. Además, una vez que la acabe podemos empezar a pedirle que lo revise y publique un libro

Ahora sólo hace falta, si el trabajo se lo permite, que lo convenza para que escriba de otras cosas

@J@viLinux: Sí. El software libre PUEDE ser la solución a la crisis… Pero… ¿lo es? Las empresas que yo conozco, las grandes, no se atreven a pasar al software libre. No se fían de quién está detrás del software. Así de sencillo.

Por ejemplo: Tú eres un pedazo de Banco de esos que vendía Hipotecas Basura y ahora recibes dinero gratis de los contribuyentes por tu mala cabeza. Tienes 10 elevado a n PC’s esparcidos por Oficinas, Servicios Centrales y Centros Diversos… miles de ellos. Digamos que con Windows * (o sea, unos pocos en 95, otros en 98, algunos en Me, bastantes en 2000 o NT, muchos en XP Pro, unos pocos en Vista, y así: lo normal, vaya). Sorprendentemente, a pesar de ello, funcionan, tus aplicaciones financieras cobran y pagan, tus PC’s de oficina imprimen documentos, etc.

Decides abrazar la fé del software libre. Entonces cambias unos pocos a Ubuntu, o Suse, o Guadalinex, o lo que te pete más.

Un buen día resulta que el driver de la impresora financiera Ollivetti 88.999 peta con el Linux que tienes. ¿A qué CAS llamas? ¿Quién te envía el PTF? ¿Olivetti? ¿Y si no?

Otro día, la aplicación que usa una vez al mes el Director General para ver cómo van sus inversiones pierde las cookies… y como el Firefox las guarda de no sé qué manera, no las puedes recuperar… Les dices: Es que como tenemos Linux que es gratis, pues hay cosas que no funcionan… y ésta es una de ellas, je, je.

Y el Director General, que ayer precisamente comió con Bill Gates en Horcher, igual te señala el camino más rápido a Recursos Humanos para que te preparen la liquidación…

Hay mucho miedo. Mucho. Casi nadie está dispuesto ni siquiera a probar.

Veremos en unos años…. a ver si alguien es capaz de contar esa historia…

@Pedro: Gracias por defender mi humilde punto de vista. Más adelante veremos cómo se desarrollan los acontecimientos, en unos meses voy a estar suficientemente liedo como para escribir poco… pero ya cambiará la cosa, ya… ¡no vais a deshaceros de mí ni con agua caliente!.

Me uno a los lamentos por el final de la serie… pero entiendo que al llegar al momento actual en tu crónica histórica no hay más opciones

Aunque también me uno a la petición de Baco sobre tus opiniones sobre el futuro de la informática, ya que tu larga experiencia te da autoridad de sobra para opinar y predecir con criterio. En especial, espero que sea sobre las aplicaciones web, tema que me toca directamente, jajaja.

Enhorabuena por todos y cada uno de los artículos de esta serie.

@Kent, Baco: No creo que las previsiones de este humilde programador frustrado puedan tener ninguna utilidad; más o menos la misma que si le preguntas al estanquero de la esquina… Lo siento, amigos, pero la bola de cristal la tengo fundida últimamente…

Porque supongo que decir que las aplicaciones se harán cada vez más utilizando tecnología internet/intranet no requiere mucha clarividencia, ¿no?

Pero del resto, no me atrevo. No creo yo que haya nadie que lo haga en serio… y acierte.

Me recuerda esto al (estúpido) chiste de aquel lugareño que se jactaba ante un veraneante de que él era capaz de, nada más nacer una creatura en el lugar, predecir a qué se iba a dedicar, con quién se iba a casar, cuántos hijos iba a tener, etc, etc. El veraneante pregunta ¿Sí…? ¿Y acierta Vd.? “Pues no, eso nunca…”.

En fin, que hacer predicciones, y que éstas acierten, es muy difícil… especialmente si se refieren al futuro.

Saludos

Jajaja, eres la leche Macluskey, como NO salían en http://www.meneame.net mas artículos tuyos me puse a buscar en donde dices que estaban toda la serie de “Historias de un viejo informatico”.

Yo empecé en el mundillo de la informática en el 94 (!en el 93 tuve un grave accidente de tráfico!), actualmente aunque trabajo desde hace 4 o 5 años como programador senior también estudio Ingeniería Informática (últimas asignaturas…) por la UNED.

Bueno, que a mi también se me va la pinza, jeje. Yo también conservo el Windows 3.0, el MS_DOS 6.2, el Lotus Smartsuite 96, el Office, el Works…

Me ha gustado muchísimo el artículo (como todos los demas, claro está) y me gustaría saber si podríamos contactar por e-mail (algo así como un privado, aunque sin malos rollos, jajaja)

@Mac

Con respecto a lo del software libre, y antes cuando cascaba un programa que hacían uds mismo ¿a quien te quejabas? Y ahora cuando casca el windows por una de las \infty formas que tiene, ¿a quien te quejas? ¿A microsoft? XD espero que con las empresas funcionen mejor que con los particulares…

Por lo menos, con el software libre puedes tener un departamento de informáticos que a las malas malas te saque del entuerto, o contratar el soporte de alguna de las grandes (SUSE, RedHat, alguna compañía local, etc.) Lógicamente esto solo vale para empresas grandes, pero las empresas pequeñas no tienen estos problemas.

De todas formas, me da la sensación que la cosa se “precipitará” por sectores. En cuanto una gran empresa del sector migre correctamente a software libre y su se ahorre unos dineros probablemente tendrá una ventaja competitiva que el resto querrá copiar, o eso creo yo. Pero esto mejor que lo diga Mac que de esto seguro que sabe un montón más que yo.

No os podéis imaginar cómo he agradecido estos artículos de nuestro amigo Macluskey. Y os voy a pegar escribir este ladrillo para contaros por que.

Yo no he estudiado ninguna ingeñería, ni siquiera un fp2. Siempre he sido muy vaguete para todo, menos para la informática a nivel usuario o a otros niveles que alguna vez me han entrado ganas de explorar, todo de una manera autodidacta eso sí, que como mi novia me dice “si es que cuando te entra la furia por algo, te entra bien”.

Aunque he trabajado siempre en el campo de la informática ya sea de técnico montando pcs, diseñador de webs, incluso algo de programación, todo pesimamente pagado cuando eres un mindundis sin ningún diplomilla en la pared. Fue hace unos 3 años cuando sufrí una transformación por una serie de circunstancias que me hicieron evolucionar y madurar de una manera brutal, a lo goku vamos xD . Lo primero que hice es buscarme un curro serio –de esos en los que te pagan el día 31 con nómina y todo-. Me costó 1 mes y unas 15 entrevistas. Acabe arto de las ETT o consultoras con sus supuestas ofertas fantasma realizadas por personas que pensaban que un disco duro es un LP de piedra, alguno os suena esto verdad?, no os dan ganas de coger y hacer como Michael Duglas en un día d furia?

Después me puse a estudiar -Creo que mi madre estuvo a punto de llevarme al psicólogo, algo raro me pasaba- Descarte una licenciatura porque uno ya ha perdido demasiado tiempo como para tirarse 5 años como poco sacándote la carrera, a parte uno con una infancia de repetidor tiene algún trauma con eso de ser el más viejo de la clase-. Así que opte por los certificados, como lo mas rápido en aprender algo que realmente me valga la pena. Me decidí por cisco ya que mientras Linux y Microsoft me resultaba familiares –jugueteaba en casa con debían y Windows 2003- las comunicaciones fuera del ámbito domestico me eran completamente desconocidas y misteriosas ¡AH, que no se usas nos zyxel de telefónica para conectarse a internet!!!, que además no usan adsl?, el acabose!!!. En fin me saque el CCNA en un año pagando un máster presencial con prácticas como mandan los cánones, no penséis que fue todo de tesking y pass4sure,…. solo un poquito xDDD.

En la empresa donde trabajaba hacia soporte a usuarios, administración del directorio activo, permisos, etc. Pero poco mas, aunque si empecé a ver las tecnologías usadas a nivel empresarial en las que nunca había tenido acceso, entre en mi primer CPD y aquello me pareció la nave de start trek. De hecho, creo que empecé a creer que a mi compañero de sistemas se le estaban afilando las orejas. Cuando termine el CCNA, volví a la calle – o a infojobs- a buscar curro. Pero ya con una autoestima mayor y valorando mas mi tiempo como para dejarme tomar el pelo.

Estuve otro mes buscando curro, preferentemente comunicaciones, pero estaba abierto a otros campos que me pudieran interesar. La verdad es que fui a entrevistas en las flipaba con los los perfiles de “Se necesita un pavo que sepa de tó al que se recompensara con 4 duros, se subcontratará a una subcontrata que a su vez te venderá al cliente final”, casi literal.

Bueno al final fui a parar a una empresa seria, como analista de sistemas –Uno de esos raros casos en los que ejerces unas funciones menores de las que pone tu contrato- en la que me ofrecían el salario que pedía, me daban comida y clases de ingles y aunque no tocaba comunicaciones –las tienen subcontratadas a BT- acepte, soy un mercenario, que le vamos a hacer. Aquí somos 3 técnicos que hacemos de tó, pero cuando digo de tó, es de toooo. Igual tenemos que levantar un servidor AIX que aguantar la típica Antonia de grandes cuentas con “este portátil que me habéis dado esta sucio”.

Y en este punto es donde los relatos de Macluskey –lo mejor que he leído en internet a nivel de blog en mucho tiempo- han puesto orden en este caos tecnológico empresarial que había en mi cabeza, ya que en esta empresa usan servidores AIX system P5, AS/400, a parte de unos cuantos minis de los que se habla en este artículo para correo, firewall, etc y otras tecnologías que me sonaban a chino mandarín cuando entre aquí y que ahora que mas y que menos, se administrar.

Gracias Muskley.

P:D. Ahora estoy a punto de terminar de sacarme el CCVP, -el profesional de vozip-, volveré a la calle a buscarme la vida, a ver que nos encontramos y si esta vez puedo entrar de lleno en las comunicaciones.

Un saludo.

@Bignoise: ¡Jo, qué comentario, amigo!

Vamos a ver: Un consejo de viejo metomentodo: En serio, pero serio que te pasas:

¡¡¡ Lo tuyo es escribir !!!

¿Qué kohoneh haces perdiendo el tiempo administrando AIX y Windows 2003, y otras tonterías, y aguantando a Antonias cualesquiera? ¿es que no ha quedado claro? Más de cien mil palabras en toda la serie, ¿y todavia no ha quedado claro…?

¡Eso queda para los que no sabemos hacer otra cosa!

Recomendación de diablo que más sabe por viejo que por diablo:

1) Desfogarse. ElCedazo es un lujo para eso. Asiático. El amigo Pedro, además de Gran Jefe y censor, es como un padre: aconseja, ayuda, admisnistra… y si hace falta, los eximios (je, je) participantes en este blog comunitario podemos echar una mano.

2) Escribes un librito, Una novelilla, una experiencia, un sucedido. Lo publicas por ahí, gratuito, que hay sitios como lulu.com para hacerlo.

3) MMmmmm ¿Dónde está el límite? ¡El cielo es el límite!

Ánimo, macho, que con ese gracejo que dios (el que más te guste) te ha dado, te puedes comer el mundo.

Dixit.

El Mac.

El hombre, por naturaleza, ¡le tiene pavor a la finitud! Pero así es la vida… finita, finita. Creo que, después de todo, los griegos tenían razón. El tiempo da círculos. Cuando se cierra uno, nace otro nuevo. Espero que el fin da esta serie sea el brotar de una nueva.

Por otro lado me parece muy bien que no puedas predecir el futuro de la informática. ¡De otro modo acabaríamos en la paradoja de Newcomb!

Saludos.

No, Lucas, no. Yo, lo que le tengo pavor es a la Infinitud… ¡la de bucles infinitos que me han dado mis programas…!

Y lo de las predicciones… es que ahora la informática no se rige por los avances tecnológicos como antes, sino por motivaciones puramente económicas, y ahí no me atrevo a decir nada.

En otros tiempos pasados sí que podía hacer predicciones, las hacía, y la mayor parte de las veces, incluso acertaba. Ahora no. Se ha vuelto muy complicado, al menos para mí. Así que prefiero no hacerlas. Para decir obviedades, ya están los consultores-de-moda…

Un saludo, amigo

Hola Macluskey, y a todos los demas que postean también. Felicidades por la seria de articulos, estoy engachadísimo . Tambien, me gustaría sugerirte una pequeña corrección, el principal mercado de SGI nunca fueron los estudios de cine, fueron los ingenieros, militares, petroleras, arquitectos y tal, viene citado en el link a la wikipedia “”Conventional wisdom holds that SGI’s core market has traditionally been Hollywood visual effects studios. In fact, SGI’s largest revenue has always been generated by government and defense applications, energy, and scientific and technical computing”".

. Tambien, me gustaría sugerirte una pequeña corrección, el principal mercado de SGI nunca fueron los estudios de cine, fueron los ingenieros, militares, petroleras, arquitectos y tal, viene citado en el link a la wikipedia “”Conventional wisdom holds that SGI’s core market has traditionally been Hollywood visual effects studios. In fact, SGI’s largest revenue has always been generated by government and defense applications, energy, and scientific and technical computing”".

Pues nada, aver como nos sorprendes con la proxima entrega

Una gozada tu serie. Uno que ya tiene cuarenta y pocos y lleva en esto desde los 18 se emociona al volver a recordar tantas y tantas anecdotas tan bien escritas.

Muchas gracias y espero que continues el máximo tiempo posible.

Christian: De acuerdo. Pero tén en cuenta que estoy contando, sobre todo, de mis recuerdos… y en los noventa, Silicon Graphics hacía su publicidad sobre todo haciéndo hincapié en el tratamiento de imágenes… y me imagino que exactamente eso es lo que hacía el Gobierno Americano: tratar imágenes para los mil proyectos de Defensa, fundamentalmente… proyectos que entonces no se podían publicitar: “Classified!”

Así que, aunque la mayor parte de sus ingresos vinieran del Gobierno, en su publicidad hablaba sobre todo de Hollywwod… unos años curiosos, los de la guerra fría…

Gracias por vuestros comentarios

Sí. El software libre PUEDE ser la solución a la crisis… Pero… ¿lo es? Las empresas que yo conozco, las grandes, no se atreven a pasar al software libre. No se fían de quién está detrás del software. Así de sencillo.

Tal vez a esas empresas que dicen ser grandes les suene de algo IBM. O los mainframes.

09/12/2009: IBM has released a new mainframe server that doesn’t include its z/OS operating system. This Enterprise Linux Server line [http://www.computerworld.com/s/article/9142007/IBM_s_newest_mainframe_is_all_Linux_] supports Red Hat or Suse. The system is packaged with mainframe management and virtualization tools. The minimum processor configuration uses two specialty mainframe processors designed for Linux. IBM wants to go after large multicore x86 Linux servers and believes the $212,000 entry price can do it.”

Aparte de la dirección del artículo de Computerworld que he pasado, también anoto una dirección oficial de IBM respecto a Linux en sus mainframes: http://www.ibm.com/systems/z/os/linux/

@Antonio: Efectivamente, IBM hace años que se ha subido al carro del “software libre”, y vende Linux en sus mainframes. Muy bonito y muy aparente.

Pero la realidad es que pocas empresas (si es que hay alguna) compran un mainframe exclusivamente con Z-Linux. El motivo es que, aparte de que zOS (el antiguo y mil veces renombrado MVS) es muuuucho mejor que cualquier otro sistema operativo existente (IBM jura que su zLinux ha “heredado” muchas de las características de su zOS, pero permíteme que lo dude, y mucho), están todos los “programas producto” que hacen de zOS algo inigualable: RACF, VSAM, CICS, IMS, DB2 (el del zOS, el de verdad, no la cosa ésa que IBM vende con el mismo nombre en otros ambientes), etc, etc.

Vale que muchos años combinados de esfuerzos de decenas o centenares de competidores hayan minado la capacidad comercial de IBM y sus mainframes, pero, créeme, siguen siendo las mejores máquinas existentes con el mejor software existente… y las que mueven el mundo, mejor, las que siguen moviendo el mundo…

Gracias por tus amables comentarios.

Si entramos en la dirección mencionada, en http://www.ibm.com/systems/z/os/linux/ y pulsamos en el enlace “Client Success Stories” nos lleva a un sitio interesante: http://www.ibm.com/systems/z/os/linux/success/index.html

Por ejemplo, pulsando en “Choose your business goal” y seleccionando “Banking / Financial Services” vemos un caso cercano a este artículo:

Banco Pastor reduces costs and improves scalability with Red Hat, SAP, and IBM solutions y abriendo dicho PDF vemos el caso, en el que se dice:

Software: Red Hat Enterprise Linux Server v5.3, SAP NetWeaver 7.0 SR3, SAP ERP 6.0 SR3, and IBM Lotus Notes for Collaboration 7.0.2 Hardware: Two IBM System z10 Business Class mainframes, with three and four IFLs

[...] the business’s need for one of the world’s most sophisticated business servers, with the equivalent com puting capacity of nearly 1,500 x86 servers, an 85 percent smaller footprint, and up to 85 percent lower energy costs.

Si se busca en dicha web, hay más casos de éxito, claro.

> Pero la realidad es que pocas empresas (si es que hay alguna) compran un mainframe exclusivamente con Z-Linux. En la wikipedia cuando alguien escribe algo así, le añaden un “Citation needed” .

.

> Gracias por tus amables comentarios. ¡Gracias por los artículos, que son muchos!

@Antonio: Que hay casos de éxito, pues claro.

Pero… analicemos un poco. Ése que comentas del Banco Pastor dice específicamente que ha implantado SAP. No estoy muy al tanto, pero, ¿SAP en el core de un banco? ¿Eso existe? Igual ahora sí, estoy un poco desconectado de estas cositas con las que tiempos ha me ganaba la vida, pero a mí me da la sensación de que habrán implantado SAP para la contabilidad, la gestión de proveedores, etc, no para las cuentas corrientes, los préstamos y demás bobadas… (aunque igual sí, ¿eh?).

En cualquier caso, lo que de verdad dice el artículo es que han implantado un ERP (SAP) y han ahorrado costes a cascoporro.

Gracias al genial SAP, independientemente de que las treintaypico mil tablitas de nada del SAP estén en un Linux, un AIX, un Solaris… o un zOS. E ndependientemente de que estén en DBN2, en Oracle, en MySQL o donde sea. Es SAP, ese muerto de SAP el que, para bien o para mal, se implanta, y lo de menos es dónde.

…Aunque, sinceramente, si sumamos costes de implantación, licencias, pérdidas de conocimiento, formación de los miles de usuarios en el nuevo sistema, etc, en fin, esas cositas que todo buen comercial siempre olvida al calcular un ROI (y yo he hecho unos pocos de estos y sé de qué hablo)… también dudo mucho de que se hayan ahorrado ni un euro… pero es una opinión personal, ¿eh?

Y, ya ves, la ventaja de escribir aquí en lugar de la wikipedia es que no tengo por qué usar citas de otros: con las mías basta. Son mis experiencias, mis conocimientos y mis anécdotas personales… y lo más normal sería que en la wikipedia usaran este blog como fuente, que es lo que es, no al revés.

Un placer debatir de temas tan interesantes…

Saludos. Mac

Ah! Se me olvidaba… ¿Te das cuenta de que el artículo está dedicado a las cosas que pasaban en los años 90. Entonces no existía Linux ni, si me apuras, internet siquiera… Hace como veinte años… Sniff, cómo pasa el tiempo…

{ 1 } Trackback

Los tormentosos años noventa(II): La imparable ascensión de los “minis“…

En meneame.net/story/tormentosos-anos-noventa-i-guerra-pcs anterior dimos un personal repaso a los hechos que acontecieron durante finales de los ochenta y la primera parte de los noventa. En ésta de hoy me centraré en las convulsiones similares que ac…

Escribe un comentario